Hemos probado las nuevas gafas de Google con Gemini: la IA y la tecnología de hoy impulsan el sueño que Glass prometía

- 5 Horas, 33 Minutos

- Xataka.com

- Tecnología

Hemos probado las nuevas gafas de Google con Gemini: la IA y la tecnología de hoy impulsan el sueño que Glass prometía

Lo de la realidad aumentada no es algo nuevo para Google. De hecho, es un segmento en el que han querido meter el pie desde hace más de una década. Glass fue el proyecto que nos hacía soñar con unas gafas con las que podíamos obtener toda la información que quisiéramos directamente desde nuestra retina. El problema es que la tecnología simplemente no estaba lista en aquel momento.

Con la llegada de la IA generativa, la balanza se ha acabado equilibrando bastante. Durante el Google I/O, la compañía mostró un prototipo de unas gafas que nos recordaban mucho a Google Glass, impulsadas ahora con Gemini. Nosotros hemos podido probar este mismo prototipo durante nuestra visita al evento y bajo estas líneas te contamos qué nos han parecido. Aviso para navegantes: aún son un prototipo, por lo que la misión de Google ha sido recopilar feedback a través de pruebas a puerta cerrada.

A Glass le faltaban dos claves: una IA como Gemini y la tecnología que tenemos hoy

El regreso de Google al terreno de las gafas inteligentes parece estar más vivo que nunca, sobre todo tras conocer el desarrollo de la plataforma Android XR y su colaboración junto a Samsung y a Qualcomm para la creación de Project Moohan, las gafas de realidad aumentada que tienen el objetivo de plantar cara a la propuesta de Apple con Vision Pro.

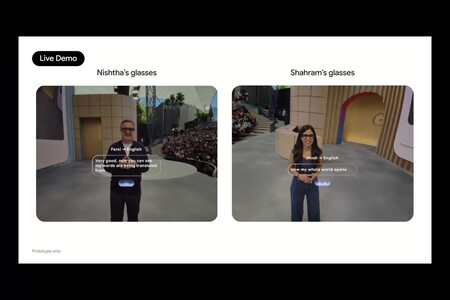

La traducción en tiempo real puede convertirse en una de las funciones más demandadas por este tipo de dispositivos | Imagen: Google

La traducción en tiempo real puede convertirse en una de las funciones más demandadas por este tipo de dispositivos | Imagen: Google

La compañía parece que vuelve con un enfoque renovado, importantes alianzas estratégicas y una tecnología mucho más madura. Android XR quiere extenderse por gafas de múltiples formatos y durante el evento hemos podido trastear un poco con sus gafas pensadas para llevarlas durante todo el día.

Google y Samsung no se han escondido con el diseño de Project Moohan y tampoco lo han hecho con estas gafas. Este enfoque discreto parece inspirado por la reciente colaboración de Meta con Ray-Ban, y es un claro reconocimiento de que las gafas inteligentes necesitan ser, ante todo, gafas que la gente quiera llevar.

La prueba (con fallos) durante la keynote del Google I/O | Imagen: Google

La prueba (con fallos) durante la keynote del Google I/O | Imagen: Google

Durante la prueba con este prototipo pude comprobar cómo Google ha integrado su asistente de inteligencia artificial Gemini en un formato que aprovecha la visión en primera persona. A diferencia de la propuesta original de Glass, donde la tecnología era protagonista, aquí la experiencia fluye de manera más natural. Nos hubiera encantado mostraros la interfaz durante la prueba o un primer plano más cercano de las propias gafas, pero lamentablemente eran algunas de las restricciones que debíamos cumplir.

El propio Sergey Brin, cofundador de Google, reconoció durante el evento los errores cometidos con Google Glass, admitiendo que entonces no entendían la complejidad de las cadenas de suministro en electrónica de consumo ni lo difícil que resultaría fabricar gafas inteligentes a un precio razonable.

La IA ve lo que tú ves

Gemini se desenvuelve realmente bien mientras interactuamos con el asistente a través de las gafas. El asistente utiliza la cámara incorporada en las gafas para ‘ver lo que nosotros vemos’. En una de los demos, me detuve frente a un cuadro y le pregunté directamente quién era su autor y qué representaba. Sin tener que especificar a qué cuadro me refería, el asistente respondió con precisión aportando datos sobre la obra y otros detalles relacionados de interés.

Prototipo de gafas en la prueba con Gemini | Imagen: Xataka

Prototipo de gafas en la prueba con Gemini | Imagen: Xataka

En otra de las pruebas, también pude saborear ligeramente su potencial capacidad para ayudarnos con cualquier tipo de tarea, preguntándole sobre el funcionamiento de una máquina de café que tenía delante de mí. El asistente no solo identificó el modelo, sino que detalló el procedimiento paso a paso para preparar un café.

A pesar de que todas las pruebas se encontraban en un entorno seguro donde los trabajadores de Google tenían el control por si sucedía algo extraño, estas pruebas me dieron a entender todo el mundo de posibilidades del que Google contaba gracias a Gemini y a una tecnología que ahora ‘sí está’.

Gemini impulsa las capacidades del dispositivo | Imagen: Google

Gemini impulsa las capacidades del dispositivo | Imagen: Google

Esta capacidad de "ver" y entender el contexto marca una diferencia sustancial respecto a los asistentes que solo dependen de comandos de voz o texto. Es como tener un compañero que observa el mundo desde tu perspectiva y te ayuda cuando lo necesitas. Un ‘todólogo’ que te ayuda en lo que sea. Y ese concepto de ayuda directa también se ha extendido en otros proyectos que Google tiene en marcha y que también pudimos ver en Google I/O, como es el caso de Search Live.

En el estado actual en el que se encontraba este prototipo, las gafas contaban con un botón táctil en una de las patillas que permite activar o pausar a Gemini, de manera que el asistente no está constantemente escuchando y observando. Además, cuando la cámara está activa, un LED se ilumina para que las personas a tu alrededor sepan que estás grabando.

Así queda el prototipo puesto durante las demos | Imagen: Xataka

Así queda el prototipo puesto durante las demos | Imagen: Xataka

La información se proyectaba desde uno de los cristales, y todo lo que escuchábamos de Gemini lo podíamos también ver en texto. En el estado actual, el texto es algo incómodo de leer, y eso que no tengo problemas de vista. Sin embargo, debemos recordar de que se trata de un prototipo muy prematuro, por lo que es una característica que seguramente cambie mucho durante el ciclo de desarrollo. Y es que cabe recordar que Android XR se está comenzando a desarrollar este mismo año para este nuevo concepto de gafas, tal y como la compañía ha desvelado durante su keynote.

Una estrategia de alianzas y precio lo serán todo para determinar su éxito

Lo que también hace distinguirse este proyecto de intentos anteriores es la estrategia de colaboración que Google está desplegando. La compañía anunció durante el I/O asociaciones con fabricantes de gafas como Gentle Monster y Warby Parker, además de profundizar su alianza tecnológica con Samsung y Qualcomm. Google está invirtiendo hasta 150 millones de dólares en su asociación con Warby Parker.

A pesar del entusiasmo, hay que ser realistas: lo que pude probar fue un prototipo muy temprano con funcionalidades limitadas y en un entorno controlado. Las demos se centraron en casos de uso muy específicos, por lo que todo nos indica que aún les falta bastante recorrido. Con Project Moohan la cosa está mucho más madura, ya que la intención es que el casco salga este mismo 2025.

Habrá que ver sobre todo precio y cómo responde Gemini en situaciones del mundo real más complejas. También falta por descubrir cómo va tomando forma Android XR, una plataforma que aún carece de identidad propia, pero que poco a poco vamos viendo de lo que es capaz.

Imagen de portada | Xataka

-

La noticia

Hemos probado las nuevas gafas de Google con Gemini: la IA y la tecnología de hoy impulsan el sueño que Glass prometía

fue publicada originalmente en

Xataka

por

Antonio Vallejo

.

0 Comentarios